Aurora polar

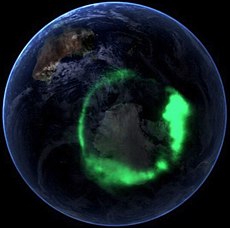

Aurora polar (o aurora polaris) es un fenómeno en forma de brillo o luminiscencia que se presenta en el cielo nocturno, generalmente en zonas polares, aunque puede aparecer en otras zonas del mundo durante breves períodos. En el hemisferio sur es conocida como Aurora austral, y en el hemisferio norte como Aurora boreal, cuyo nombre proviene de Aurora, la diosa romana del amanecer, y de la palabra griega Bóreas, que significa norte.

Los mejores momentos para observarla son entre septiembre y marzo en el hemisferio norte (aurora boreal), y entre marzo y septiembre en el hemisferio sur (aurora austral).

Origen[

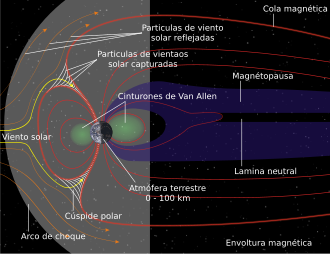

Una aurora se produce cuando una eyección de partículas solares cargadas (radiación cósmica) choca con la magnetósfera de la Tierra. Esta "esfera" que nos rodea obedece al campo magnético generado por el núcleo de la Tierra, formada por líneas invisibles que parten de los dos polos, como un imán. Además existen fenómenos muy energéticos, como las fulguraciones o las eyecciones de masa coronal que incrementan la intensidad del viento solar. Cuando dicha masa solar choca con nuestra esfera protectora, estas radiaciones solares, también conocidas con el nombre de viento solar, se desplazan a lo largo de dicha esfera. En el hemisferio que se encuentra en la etapa nocturna de la Tierra en los polos, donde están las otras líneas de campo magnético, se va almacenando dicha energía hasta que no se puede almacenar más, y esta energía almacenada se dispara en forma de radiaciones electromagnéticas sobre la ionosfera terrestre, creadora, principalmente, de dichos efectos visuales.

El Sol, situado a 150 millones de km de la Tierra, está emitiendo continuamente partículas que constituye un flujo de partículas denominado viento solar. La superficie del Sol o fotosfera se encuentra a unos 6000 °C; sin embargo, cuando se asciende en la atmósfera del Sol hacia capas superiores la temperatura aumenta en vez de disminuir. La temperatura de la corona solar, la zona más externa que se puede apreciar a simple vista solo durante los eclipses totales de Sol, alcanza temperaturas de hasta 3 millones de grados. Al ser mayor la presión en la superficie del Sol que la del espacio que le rodea, las partículas cargadas que se encuentran en la atmósfera del Sol tienden a escapar y son aceleradas y canalizadas por el campo magnético del Sol, alcanzando la órbita de otros cuerpos de gran tamaño como la Tierra. Además existen fenómenos muy energéticos, como las fulguraciones o las eyecciones de masa coronal que incrementan la intensidad del viento solar.

Las partículas del viento solar viajan a velocidades en un rango aproximado de 490 a 1000 km/s, de modo que recorren la distancia entre el Sol y la Tierra en aproximadamente dos días. En las proximidades de la Tierra, el viento solar es deflectado por el campo magnético de la Tierra o magnetósfera. Las partículas fluyen en la magnetósfera de la misma forma que lo hace un río alrededor de una piedra o de un pilar de un puente. El viento solar también empuja a la magnetósfera y la deforma de modo que, en lugar de un haz uniforme de líneas de campo magnético como las que mostraría un imán imaginario colocado en dirección norte-sur en el interior de la Tierra, lo que se tiene es una estructura alargada con forma de cometa con una larga cola en la dirección opuesta al Sol. Las partículas cargadas tienen la propiedad de quedar atrapadas y viajar a lo largo de las líneas de campo magnético, de modo que seguirán la trayectoria que le marquen estas. Las partículas atrapadas en la magnetósfera colisionan con los átomos y moléculas de la atmósfera de la Tierra que se encuentran en su nivel más bajo de energía, en el denominado nivel fundamental. El aporte de energía proporcionado a estas provoca estados de alta energía también denominados de excitación. En poco tiempo, del orden de las millonésimas de segundo, o incluso menos, los átomos y moléculas vuelven al nivel fundamental perdiendo esa energía en una longitud de onda en el espectro visible al ser humano, lo que vulgarmente viene a ser la luz en sus diferentes colores. Las auroras se mantienen por encima de los 95 km respecto a la superficie terrestre porque a esa altitud la atmósfera ya es suficientemente densa como para que los choques con las partículas cargadas ocurran con tanta frecuencia que los átomos y moléculas estén prácticamente en reposo. Por otro lado, las auroras no pueden estar más arriba de los 500-1000 km porque a esa altura la atmósfera es demasiado tenue —poco densa— como para que las pocas colisiones que ocurren tengan un efecto significativo en su aspecto lumínico.

Los colores y las formas de las auroras

Las auroras tienen formas, estructuras y colores muy diversos que además cambian rápidamente con el tiempo. Durante una noche, la aurora puede comenzar como un arco aislado muy alargado que se va extendiendo en el horizonte, generalmente en dirección este-oeste. Cerca de la medianoche el arco puede comenzar a incrementar su brillo, pueden formarse ondas o rizos a lo largo del arco y también estructuras verticales que se parecen a rayos de luz muy alargados y delgados. De repente la totalidad del cielo puede llenarse de bandas, espirales, y rayos de luz que tiemblan y se mueven rápidamente por el horizonte. Su actividad puede durar desde unos pocos minutos hasta horas. Cuando se aproxima el alba todo el proceso parece calmarse y tan solo algunas pequeñas zonas del cielo aparecen brillantes hasta que llega la mañana. Aunque lo descrito es una noche típica de auroras, nos podemos encontrar múltiples variaciones sobre el mismo tema.

Los colores que vemos en las auroras dependen de la especie atómica o molecular que las partículas del viento solar excitan y del nivel de energía que esos átomos o moléculas alcanzan. Por ejemplo no es lo mismo que la excitación se produzca en una zona con una atmósfera con niveles muy altos de oxígeno que en otra con niveles muy bajos de este.

El oxígeno es responsable de los dos colores primarios de las auroras. El verde/amarillo se produce a una longitud de onda energética de 557,7 nm, mientras que el color más rojo y morado lo produce una longitud menos frecuente en estos fenómenos, a 630,0 nm. Para entender mejor estar relación se recomienda buscar información sobre el espectro electromagnético en especial el rango visible.

El nitrógeno, al que una colisión le puede desligar alguno de sus electrones de su capa más externa, produce una luz azulada, mientras que las moléculas de nitrógeno son muy a menudo responsables de la coloración rojo/púrpura de los bordes más bajos de las auroras y de las partes más externas curvadas.

El proceso es similar al que ocurre en los tubos de neón de los anuncios o en los tubos de televisión. En un tubo de neón, el gas se excita por corrientes eléctricas y al perder su energía en forma de luz se forma la típica luz rosa que todos conocemos. En una pantalla de televisión un haz de electrones controlado por campos eléctricos y magnéticos incide sobre la misma, haciéndola brillar en diferentes colores dependiendo del revestimiento químico de los productos fosforescentes contenidos en el interior de la pantalla.

Ciencia y mitología

La auroras boreales se observaron y probablemente impresionaron mucho a los antiguos. Tanto en Occidente como en China, las auroras fueron vistas como serpientes o dragones en el cielo.

Las auroras boreales han sido estudiadas científicamente a partir del siglo XVII. En 1621, el astrónomo francés Pierre Gassendi describe este fenómeno observado en el sur de Francia y le da el nombre de aurora polar. En el siglo XVIII, el astrónomo británico Edmond Halley sospecha que el campo magnético de la Tierra desempeña un papel en la formación de la aurora boreal.

Henry Cavendish, en 1768, logra evaluar la altitud en la que se produce el fenómeno, pero no fue hasta 1896 cuando reproduce el en el laboratorio de Kristian Birkeland con los movimientos de las partículas cargadas en un campo magnético, facilitando la comprensión del mecanismo de formación de auroras.

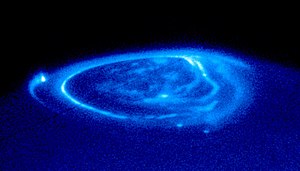

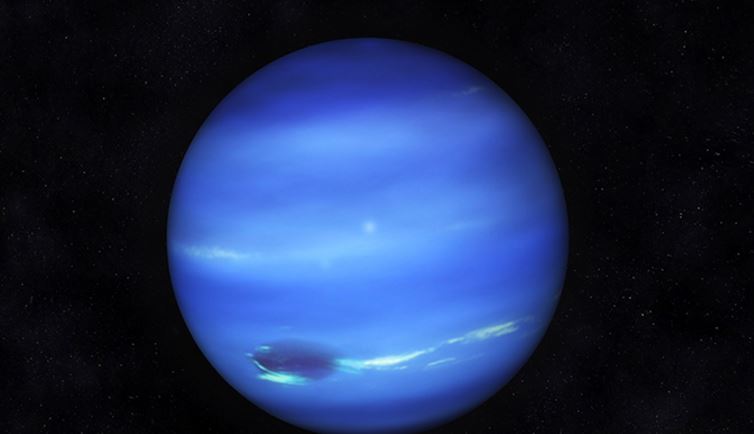

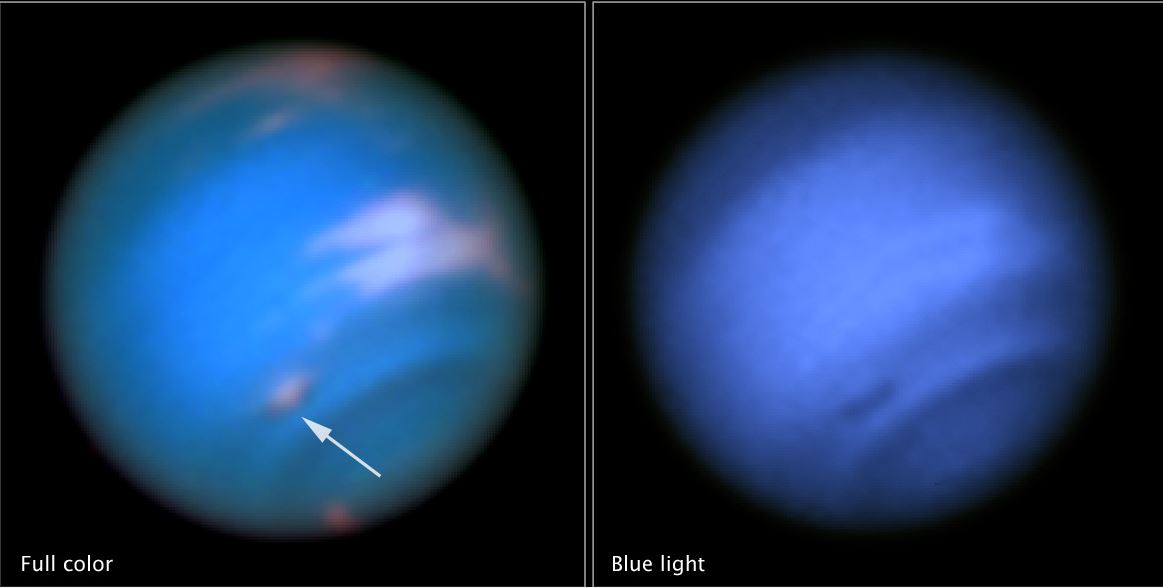

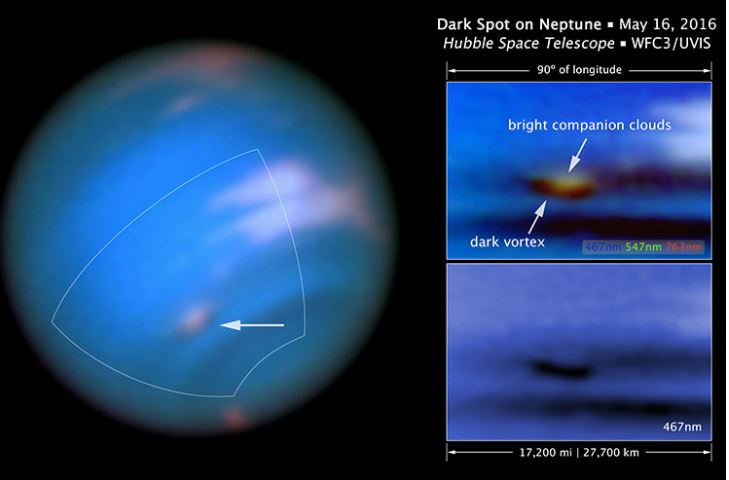

Auroras en otros planetas[editar]

Este fenómeno existe también en otros planetas del sistema solar, los cuales tienen comportamientos similares al planeta Tierra. Tal es el caso de Júpiter y Saturno, que poseen campos magnéticos más fuertes que la Tierra. Urano y Neptunotambién poseen campos magnéticos y ambos poseen amplios cinturones de radiación. Las auroras han sido observadas en ambos planetas con el telescopio Hubble.

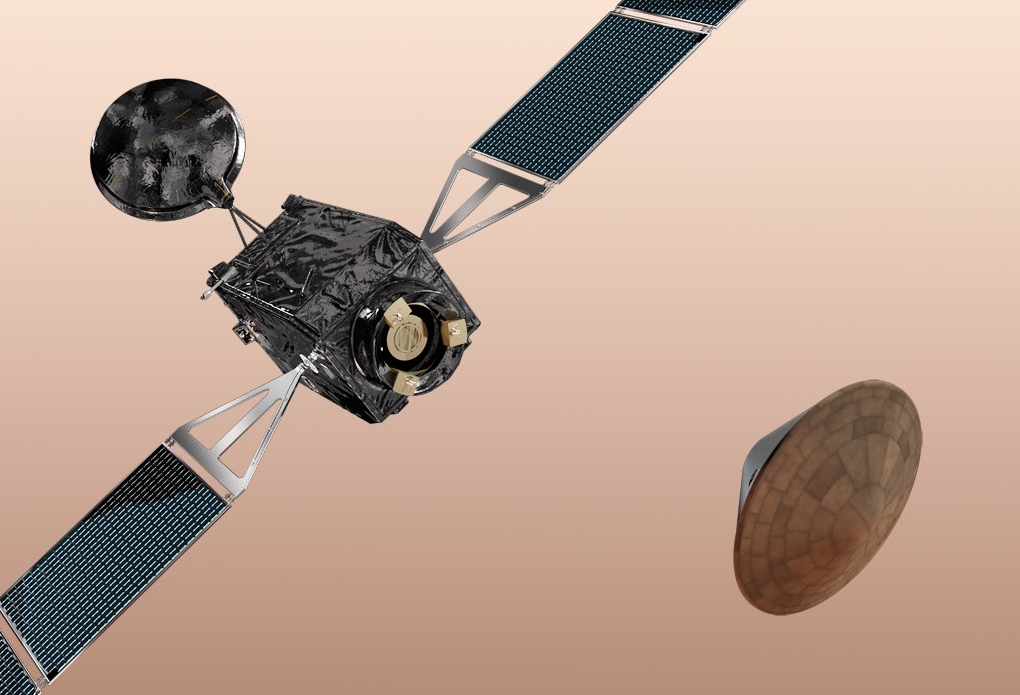

Los satélites de Júpiter, especialmente Ío, presentan gran presencia de auroras. Las auroras han sido detectadas también en Marte por la nave Mars Express, durante unas observaciones realizadas en 2004 y publicadas un año más tarde. Martecarece de un campo magnético análogo al terrestre, pero sí posee campos locales, asociados a su corteza. Son estos, al parecer, los responsables de las auroras en este planeta.